Modèles de Stable Diffusion: personnalisation et options

Le tuning est un excellent moyen d'améliorer chaque voiture ou gadget. Les réseaux neuronaux génératifs peuvent également être réglés. Aujourd'hui, nous ne souhaitons pas approfondir la structure de la diffusion stable, mais nous voulons obtenir de meilleurs résultats qu'avec une configuration standard.

Il existe deux moyens simples d'y parvenir : l'installation de modèles personnalisés et l'utilisation des options d'optimisation standard. Dans cet article, nous verrons comment installer de nouveaux modèles dans Stable Diffusion et quelles options nous permettent d'utiliser le matériel plus efficacement.

Si vous souhaitez partager des photos amusantes de chats mignons ou de plats succulents, vous les publiez généralement sur Instagram. Si vous développez des applications et souhaitez mettre le code à la disposition de tous, vous le publiez sur GitHub. Mais si vous entraînez un modèle d'IA graphique et que vous souhaitez le partager, vous devriez vous intéresser à CivitAI. Il s'agit d'une vaste plateforme permettant de partager les connaissances et les résultats avec les membres de la communauté.

Avant de commencer le téléchargement, vous devez changer le répertoire de travail. Tous les modèles d'IA dans Stable Diffusion sont placés dans le répertoire "models":Avant de commencer le téléchargement, vous devez changer le répertoire de travail. Tous les modèles d'IA de Stable Diffusion sont placés dans le répertoire "models" :

cd stable-diffusion-webui/models/Stable-diffusionVérifions quels sont les modèles fournis par défaut :

ls -a'Put Stable Diffusion checkpoints here.txt' v1-5-pruned-emaonly.safetensors

Il n'y a qu'un seul modèle avec le nom "v1-5-pruned-emaonly" et l'extension "safetensors". Ce modèle est un bon point de départ, mais nous avons cinq modèles plus intéressants. Nous allons les télécharger et les comparer avec le modèle standard.

Invitations à la diffusion stable

Pour montrer visuellement la différence entre les deux modèles, nous avons créé des messages-guides simples :

princess, magic, fairy tales, portrait, 85mm, colorful

Pour de nombreux modèles, la représentation précise de la géométrie et des traits du visage peut constituer un défi important. Pour y remédier, ajoutez des invites négatives pour vous assurer que les images sont générées sans ces caractéristiques :

poorly rendered face, poorly drawn face, poor facial details, poorly drawn hands, poorly rendered hands, low resolution, bad composition, mutated body parts, blurry image, disfigured, oversaturated, bad anatomy, deformed body features

Définissez la valeur maximale des pas d'échantillonnage (150) pour obtenir plus de détails dans le résultat.

Modèle standard

Le modèle standard donne de bons résultats dans ce type de tâches. Cependant, certains détails ne sont pas tout à fait exacts. Par exemple, il y a un problème avec les yeux : ils sont clairement disproportionnés :

Si vous regardez le diadème, il est également tordu et asymétrique. Le reste des détails est bien exécuté et correspond aux indications données. L'arrière-plan est flou parce que nous avons choisi l'option "85 mm". Il s'agit d'une longueur focale très couramment utilisée pour les portraits dans la photographie professionnelle.

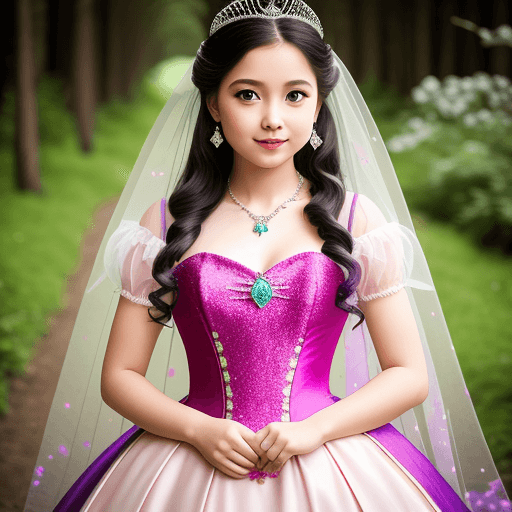

Vision réaliste

Ce modèle est idéal pour les portraits. L'image apparaît comme si elle avait été prise avec un objectif de qualité ayant la longueur focale spécifiée. Les proportions du visage et du corps sont exactes, la robe est parfaitement ajustée et le diadème sur la tête est esthétiquement plaisant :

À propos, l'auteur recommande d'utiliser le modèle suivant pour les questions négatives :

deformed iris, deformed pupils, semi-realistic, cgi, 3d, render, sketch, cartoon, drawing, anime:1.4), text, close up, cropped, out of frame, worst quality, low quality, jpeg artifacts, ugly, duplicate, morbid, mutilated, extra fingers, mutated hands, poorly drawn hands, poorly drawn face, mutation, deformed, blurry, dehydrated, bad anatomy, bad proportions, extra limbs, cloned face, disfigured, gross proportions, malformed limbs, missing arms, missing legs, extra arms, extra legs, fused fingers, too many fingers, long neck

Mais même avec nos questions simples, le résultat est excellent.

Téléchargez le modèle ici : Vision réalisteDélibérée

Un autre modèle étonnant pour ce type d'usage. Ici aussi, les détails sont bien élaborés, mais soyez prudent et surveillez le nombre de doigts. Il s'agit d'un problème très courant avec les réseaux neuronaux : ils peuvent souvent dessiner des doigts supplémentaires, voire des membres entiers.

La création de lignes visuelles est l'une des techniques cinématographiques préférées. Ainsi, ce modèle a également choisi de dessiner une personne sur fond de sentier forestier.

Téléchargez le modèle ici : Délibéré

OpenJourney

Parmi les réseaux neuronaux génératifs, Midjourney (MJ) a fait l'objet d'une attention particulière. MJ a été un pionnier dans ce domaine et est souvent cité en exemple. Les images qu'il crée ont un style unique. OpenJourney s'inspire du style MJ et est une diffusion stable convenablement réglée.

Les images générées ressemblent à un dessin animé. Elles sont vibrantes et lumineuses. Pour de meilleurs résultats, ajoutez l'invite de style mdjrny-v4

Téléchargez le modèle ici : OpenJourney

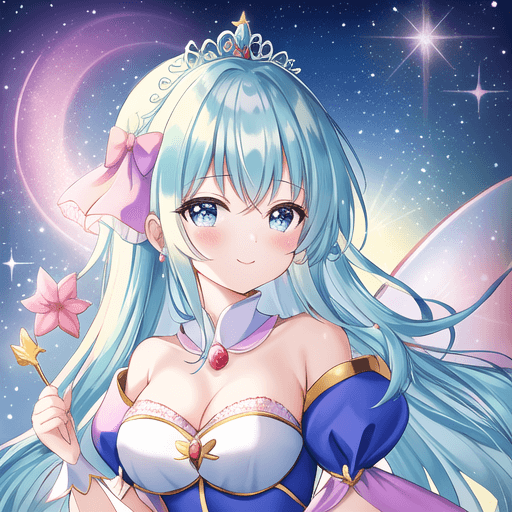

Tout

Ce modèle crée des images à la manière d'un dessinateur professionnel de manga (personne qui dessine des bandes dessinées). Ainsi, nous avons obtenu une princesse de style anime.

Ce modèle est entraîné sur des images d'une résolution de 768x768. Vous pouvez définir cette résolution pour obtenir de meilleurs résultats que la résolution standard de 512x512.

Téléchargez le modèle ici : Tout

Entreprise Memphis

Ce style d'images a connu une grande popularité au début des années 2020 et a été largement utilisé comme style d'entreprise dans différentes sociétés de haute technologie. Malgré les critiques, on le retrouve souvent dans les présentations et les sites web.

La princesse s'est avérée être minimaliste, mais assez jolie. Les détails que le modèle a placés sur l'arrière-plan sont particulièrement amusants.

Téléchargez le modèle ici : Corporate Memphis

Options de diffusion stable

La diffusion stable consomme beaucoup de ressources, c'est pourquoi de nombreuses options ont été développées. La plus populaire d'entre elles est --xformers. Cette option active deux mécanismes d'optimisation. Le premier réduit la consommation de mémoire et le second est utilisé pour augmenter la vitesse.

Si vous essayez d'ajouter --xformers sans étapes supplémentaires, vous obtiendrez une erreur indiquant que les paquets(torch et torchvision) sont compilés pour différentes versions de CUDA®. Pour résoudre ce problème, nous devons entrer dans l'environnement virtuel Python (venv) qui est utilisé pour Stable Diffusion. Ensuite, installez les paquets pour la version souhaitée de CUDA® (v1.18).

Tout d'abord, nous devons mettre à jour le cache des paquets apt et installer le programme d'installation des paquets pour Python (pip). L'étape suivante consiste à activer Python venv avec le script activate:

source stable-diffusion-webui/venv/bin/activateAprès cela, l'invite de la ligne de commande devient (venv) username@hostname:~$. Installons les paquets torch et torchvision avec CUDA® 11.8 :

pip install torch==2.0.0+cu118 torchvision==0.15.1+cu118 --index-url https://download.pytorch.org/whl/cu118Ce processus peut prendre plusieurs minutes car les paquets sont assez volumineux. Vous aurez juste le temps de vous servir un café. Enfin, vous pouvez désactiver l'environnement virtuel et démarrer Stable Diffusion avec l'option --xformers (remplacez [user] et [password] par vos propres valeurs) :

deactivate./webui --xformers --listen --gradio-auth [user]:[password]L'alternative la plus rapide à --xformers est --opt-sdp-no-mem-attention, qui consomme plus de mémoire mais fonctionne un peu plus rapidement. Vous pouvez utiliser cette option sans étapes supplémentaires.

Conclusion

Aujourd'hui, nous avons examiné les capacités de la diffusion stable lorsqu'elle est combinée à d'autres modèles ajoutés et à des options d'optimisation. N'oubliez pas qu'en augmentant ou en diminuant le nombre d'étapes d'échantillonnage, vous pouvez ajuster le niveau de détail de l'image finale.

Bien entendu, il ne s'agit là que d'une petite partie de ce que vous pouvez faire avec un tel réseau neuronal génératif. Commandez donc un serveur GPU dès maintenant et commencez à expérimenter. De nombreuses autres découvertes et opportunités vous attendent. Des cartes vidéo rapides et puissantes vous aideront à gagner du temps et à générer des images intéressantes.

Voir aussi :

Mis à jour: 04.01.2026

Publié: 25.11.2024