Avantages et inconvénients du partage du GPU

La loi de Moore est restée d'actualité pendant près d'un demi-siècle. Les puces des processeurs contiennent toujours plus de transistors et les technologies progressent chaque jour. L'évolution de la technologie s'accompagne de celle de notre approche de l'informatique. L'essor de certaines tâches informatiques a considérablement influencé le développement du matériel. Par exemple, les appareils conçus à l'origine pour le traitement graphique sont aujourd'hui des outils essentiels et abordables pour les réseaux neuronaux modernes.

La gestion des ressources informatiques s'est également transformée. Aujourd'hui, les services de masse utilisent rarement des ordinateurs centraux, comme c'était le cas dans les années 1970 et 1980. Ils préfèrent les services en nuage ou la construction de leur propre infrastructure. Cette évolution a modifié les demandes des clients, qui privilégient une mise à l'échelle rapide et à la demande, ainsi qu'une utilisation maximale des ressources informatiques allouées.

Les technologies de virtualisation et de conteneurisation sont apparues comme des solutions. Les applications sont désormais regroupées dans des conteneurs avec toutes les bibliothèques nécessaires, ce qui simplifie le déploiement et la mise à l'échelle. Cependant, la gestion manuelle est devenue impraticable lorsque le nombre de conteneurs a grimpé en flèche pour atteindre des milliers. Des orchestrateurs spécialisés comme Kubernetes assurent désormais une gestion et une mise à l'échelle efficaces. Ces outils sont devenus un élément essentiel de toute infrastructure informatique moderne.

Virtualisation des serveurs

Parallèlement, les technologies de virtualisation ont évolué, permettant la création d'environnements isolés au sein d'un même serveur physique. Les machines virtuelles se comportent de la même manière que les serveurs physiques ordinaires, ce qui permet d'utiliser des outils de gestion standard. Selon l'hyperviseur, une API spécialisée est souvent incluse, facilitant l'automatisation des procédures de routine.

Toutefois, cette flexibilité s'accompagne d'une sécurité réduite. Les attaquants ne ciblent plus les machines virtuelles individuelles, mais exploitent les vulnérabilités de l'hyperviseur. En prenant le contrôle d'un hyperviseur, les attaquants peuvent accéder à volonté à toutes les machines virtuelles associées. Malgré les améliorations constantes de la sécurité, les hyperviseurs modernes restent des cibles attrayantes.

La virtualisation traditionnelle répond à deux problèmes clés. Premier point : elle garantit l'isolement des machines virtuelles les unes par rapport aux autres. Les solutions "bare-metal" évitent ce problème car les clients louent des serveurs physiques entiers qu'ils contrôlent. Mais pour les machines virtuelles, l'isolation est basée sur un logiciel au niveau de l'hyperviseur. Une erreur de code ou un bogue aléatoire peut compromettre cette isolation, entraînant un risque de fuite ou de corruption des données.

Le deuxième problème concerne la gestion des ressources. S'il est possible de garantir l'allocation de ressources à des machines virtuelles spécifiques, la gestion d'un grand nombre de machines pose un dilemme. Les ressources peuvent être sous-utilisées, ce qui se traduit par une diminution du nombre de machines virtuelles par serveur physique. Ce scénario n'est pas rentable pour l'infrastructure et conduit inévitablement à des augmentations de prix.

Une autre solution consiste à utiliser des mécanismes de gestion automatique des ressources. Bien qu'une machine virtuelle se voie attribuer des caractéristiques déclarées spécifiques, en fait, seul le minimum requis est fourni dans ces limites. Si la machine a besoin de plus de temps processeur ou de mémoire vive, l'hyperviseur tentera de le lui fournir, mais ne peut le garantir. Cette situation est similaire à la surréservation dans les avions, lorsque les compagnies aériennes vendent plus de billets qu'il n'y a de places disponibles.

La logique est identique. Si les statistiques montrent qu'environ 10 % des passagers n'arrivent pas à temps pour leur vol, les compagnies aériennes peuvent vendre 10 % de billets en plus avec un risque minimal. Si tous les passagers arrivent, certains n'auront pas de place à bord. La compagnie aérienne devra faire face à des conséquences mineures sous la forme d'une indemnisation, mais elle continuera probablement à appliquer cette pratique.

De nombreux fournisseurs d'infrastructures emploient une stratégie similaire. Certains sont transparents à ce sujet, déclarant qu'ils ne garantissent pas une disponibilité constante des ressources informatiques mais offrent des prix considérablement réduits. D'autres utilisent des mécanismes similaires sans en faire la publicité. Ils font le pari que tous les clients n'utiliseront pas systématiquement 100 % des ressources de leur serveur et que, même si certains le font, ils seront minoritaires. Pendant ce temps, les ressources inutilisées génèrent des bénéfices.

Dans ce contexte, les solutions "bare-metal" présentent un avantage. Elles garantissent que les ressources allouées sont entièrement gérées par le client et ne sont pas partagées avec d'autres utilisateurs du fournisseur d'infrastructure. Cela élimine les scénarios dans lesquels une charge élevée de l'utilisateur d'un serveur voisin a un impact négatif sur les performances.

Virtualisation du GPU

La virtualisation classique est inévitablement confrontée au défi de l'émulation des dispositifs physiques. Pour réduire les frais généraux, des technologies spéciales ont été développées pour permettre aux machines virtuelles d'accéder directement aux périphériques physiques du serveur. Cette approche fonctionne bien dans de nombreux cas, mais lorsqu'elle est appliquée aux processeurs graphiques, elle crée des limitations immédiates. Par exemple, si un serveur dispose de 8 GPU, seules 8 machines virtuelles peuvent y accéder.

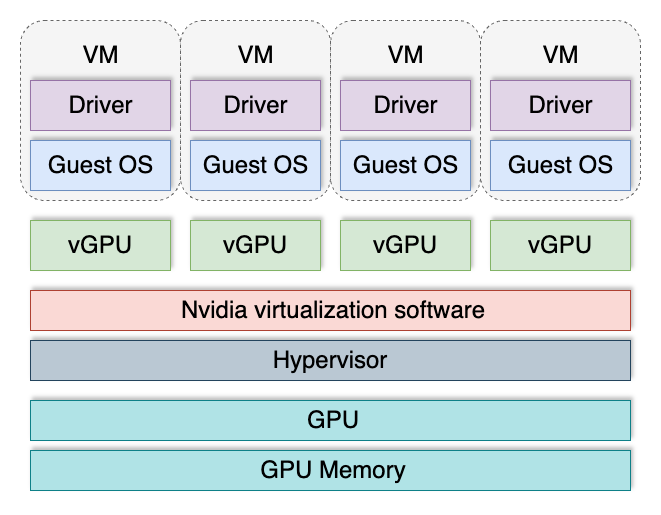

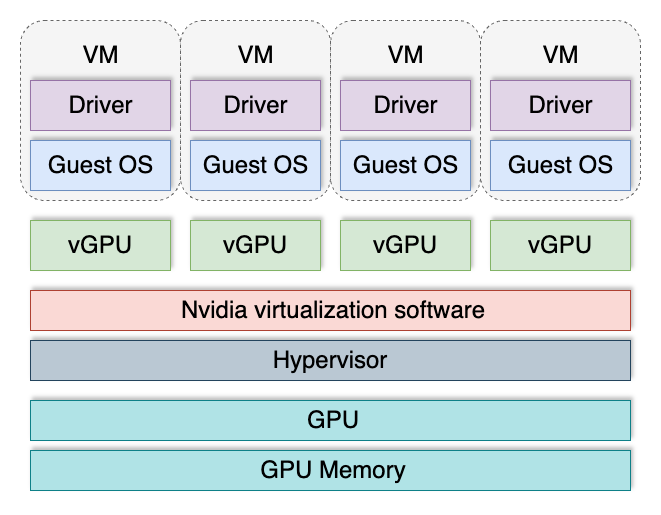

La technologie vGPU a été inventée pour pallier cette limitation. Elle divise un GPU en plusieurs GPU logiques, qui peuvent ensuite être assignés à des machines virtuelles. Cela permet à chaque machine virtuelle d'obtenir sa "part de gâteau", et leur nombre total n'est plus limité par le nombre de cartes vidéo installées sur le serveur.

Les GPU virtuels sont le plus souvent utilisés lors de la mise en place de VDI (Virtual Desktop Infrastructure) dans les domaines où les machines virtuelles ont besoin d'une accélération 3D. Par exemple, le poste de travail virtuel d'un concepteur ou d'un planificateur implique généralement un traitement graphique. La plupart des applications dans ces domaines effectuent des calculs à la fois sur le processeur central et sur le GPU. Cette approche hybride augmente considérablement la productivité et garantit une utilisation optimale des ressources informatiques disponibles.

Toutefois, cette technologie présente plusieurs inconvénients. Elle n'est pas supportée par tous les GPU et n'est disponible que dans le segment des serveurs. La prise en charge dépend également de la version installée du système d'exploitation et du pilote GPU. vGPU possède un mécanisme de licence distinct, ce qui augmente considérablement les coûts d'exploitation. En outre, ses composants logiciels peuvent potentiellement servir de vecteurs d'attaque.

Récemment, des informations ont été publiées sur huit vulnérabilités affectant tous les utilisateurs de GPU NVIDIA®. Six vulnérabilités ont été identifiées dans les pilotes de GPU et deux dans le logiciel vGPU. Ces problèmes ont été rapidement résolus, mais ils rappellent que les mécanismes d'isolation de ces systèmes ne sont pas sans faille. Une surveillance constante et l'installation opportune des mises à jour restent les principaux moyens de garantir la sécurité.

Lors de la mise en place d'une infrastructure destinée à traiter des données confidentielles et sensibles, toute virtualisation devient un facteur de risque potentiel. Dans ce cas, une approche "bare-metal" peut offrir une meilleure qualité et une meilleure sécurité.

Conclusion

La mise en place d'une infrastructure informatique nécessite toujours une évaluation des risques. Les questions clés à se poser sont les suivantes : Les données des clients sont-elles protégées en toute sécurité ? Les technologies choisies créent-elles des vecteurs d'attaque supplémentaires ? Comment isoler et éliminer les vulnérabilités potentielles ? Répondre à ces questions permet de faire des choix éclairés et de se prémunir contre des problèmes futurs.

Chez LeaderGPU, nous sommes parvenus à une conclusion claire : actuellement, la technologie bare-metal est supérieure pour assurer la sécurité des données des utilisateurs tout en servant d'excellente base pour construire un cloud bare-metal. Cette approche permet à nos clients de conserver leur flexibilité sans prendre les risques supplémentaires associés à la virtualisation des GPU.

Voir aussi:

Mis à jour: 04.01.2026

Publié: 23.01.2025